Concours pilote de subventions de Synthèse des connaissances de l'automne 2013 : Rapport final

Janvier 2015

Table des matières

- Résumé

- Introduction

- Aperçu du concours

- Méthodes

- Résumé des résultats

- Annexe 1 : Données démographiques des sondages

- Annexe 2 : Résultats détaillés du sondage

Résumé

Les IRSC ont élaboré une nouvelle série de programmes ouverts et de nouveaux processus d'évaluation par les pairs qui comprennent un certain nombre d'éléments conceptuels novateurs. Afin de s'assurer que les nouveaux éléments sont appropriés et bien mis en œuvre, les IRSC les mettent à l'essai en utilisant des concours ouverts actuels, notamment le programme de Synthèse des connaissances. Les participants au projet pilote de Synthèse des connaissances de l'automne 2013 (administrateurs de recherche, candidats et évaluateurs) ont été sondés au terme de ce projet pilote afin de recueillir leurs commentaires concernant les nouveaux processus et éléments conceptuels. Les réponses ont été compilées et sont résumées ci-dessous.

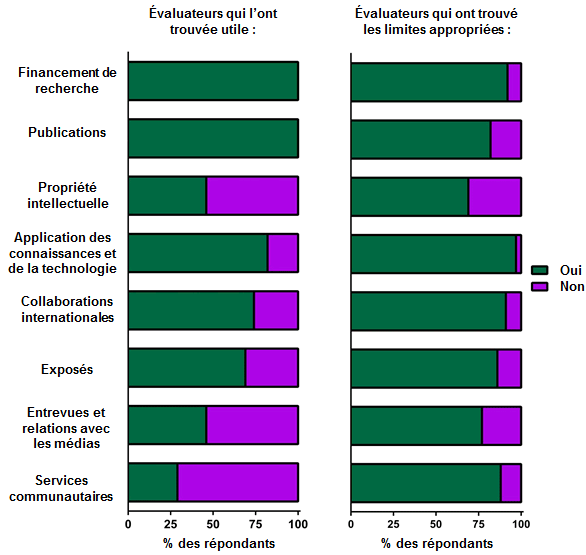

Efficacité du processus de demande structurée

Les candidats et les administrateurs de recherche ont trouvé le formulaire de demande structurée assez facile à utiliser; cependant, ceux qui soumettaient à nouveau d'anciennes demandes ont eu de la difficulté à adapter leur demande au nouveau format. Plus de 50 % des candidats ont trouvé contraignante la limite de caractères dans la demande structurée; toutefois, la majorité des évaluateurs ont trouvé la limite de caractères appropriée, et certains candidats étaient arrivés à inclure des renseignements pertinents dans leur demande plus habilement que d'autres. Les évaluateurs ont trouvé que certaines sections du CV académique des IRSC utilisé pour ce concours n'étaient pas pertinentes, à savoir les Entrevues et relations avec les médias et les Services communautaires. Cette rétroaction sera prise en considération lors de l'élaboration du CV abrégé du volet Projet, qui remplacera désormais le CV académique des IRSC pour les projets pilotes et les concours du volet Projet.

Impact sur la charge de travail des évaluateurs

La majorité des évaluateurs de l'étape 1 ont trouvé la charge de travail acceptable, et les évaluateurs ont passé en moyenne moins de temps à lire et à évaluer une demande pour ce concours pilote que pour le concours de Synthèse des connaissances précédent (printemps 2013).

La majorité des évaluateurs de l'étape 2 ont trouvé que la charge de travail était raisonnable, et que le processus d'évaluation prenait moins de temps et qu'il était plus facile que dans les précédents concours. Les évaluateurs de l'étape 2 ont passé une journée (huit heures) en réunion en personne par rapport à une réunion de comité de trois jours pour les précédents concours.

Clarté des critères et de l'échelle de sélection

Les candidats comme les évaluateurs de l'étape 1 ont eu de la difficulté à faire la distinction entre « Qualité de l'idée » et « Importance de l'idée ». Un peu plus de 50 % des candidats ont convenu que les critères de sélection devraient avoir une pondération égale. Les autres candidats avaient tendance à considérer que la section Approche devrait compter plus que la qualité et l'importance de l'idée. Les évaluateurs de l'étape 1 ont trouvé que les descripteurs de l'échelle de sélection étaient clairs et utiles, et que l'échelle de sélection était suffisamment large pour que des différences significatives entre les demandes soient mises en évidence. La majorité des évaluateurs de l'étape 1 ont déclaré avoir utilisé l'ensemble des critères de sélection (A à E) pour l'évaluation des demandes; toutefois, moins de 25 % des évaluateurs de l'étape 2 étaient du même avis. Une analyse rapide du pourcentage des cotes de A à E qui ont été attribuées a montré que plus de 70 % des cotes étaient des A ou des B. Cela a compliqué le classement des demandes ayant sensiblement la même cote pour les évaluateurs de l'étape 2. Beaucoup de candidats et d'évaluateurs de l'étape 1 ont trouvé que les critères de sélection permettaient aux candidats de communiquer efficacement leur approche d'application des connaissances intégrée (ACI). Environ deux tiers des candidats ont trouvé qu'ils pouvaient communiquer leur approche d'application des connaissances intégrée aussi bien que lors des précédents concours.

Efficacité du processus d'évaluation structuré

Étape 1 – La majorité des évaluateurs étaient satisfaits de la feuille de travail de l'évaluateur, mais certains auraient aimé avoir plus d'espace pour écrire des commentaires, particulièrement dans la section Approche. Un peu plus de la moitié des évaluateurs ont lu les évaluations préliminaires faites par leurs pairs pour la même demande; toutefois, cette lecture n'a pas souvent influencé les évaluateurs au moment de faire leurs propres évaluations. Seulement le quart des évaluateurs ont pris part à une discussion en ligne. La principale raison donnée par ceux qui n'ont pas participé était que leurs évaluations n'avaient pas été terminées à temps. Environ 50 % des évaluateurs de l'étape 2 ont indiqué que les évaluateurs de l'étape 1 n'ont pas fourni assez de commentaires pour justifier les cotes attribuées, et que cela compliquait l'évaluation des demandes qui leur étaient assignées.

Étape 2 – Tous les évaluateurs ont consulté les demandes et les documents d'évaluation de l'étape 1, et ont indiqué qu'ils ressentaient le besoin d'utiliser les deux. Des évaluateurs se sont sentis mal à l'aise de devoir accepter un certain nombre de demandes alors qu'ils ne croyaient pas qu'elles devaient être financées (ou vice versa). D'autres pensaient au contraire que c'était approprié. La majorité des évaluateurs ont lu les commentaires et les décisions (d'accepter ou non) des autres évaluateurs; cela ne les a cependant pas souvent influencés au moment de faire leurs propres évaluations. La majorité des évaluateurs ont indiqué que la réunion de comité en personne était nécessaire, et que la discussion devrait principalement porter sur les demandes qui sont près du seuil de financement. Les évaluateurs ont trouvé les instructions données à la réunion utiles, et ont trouvé l'outil de vote convivial.

Expérience de RechercheNet

Les évaluateurs des étapes 1 et 2 ont trouvé RechercheNet convivial, et ont pu utiliser efficacement les nouveaux éléments intégrés à RechercheNet pour supporter les nouveaux éléments conceptuels. Des instructions supplémentaires pour les évaluateurs de l'étape 1 dans le guide d'évaluation par les pairs (p. ex. des instructions étape par étape) seraient utiles pour les prochains concours.

Satisfaction globale à l'égard de la structure du volet Projet

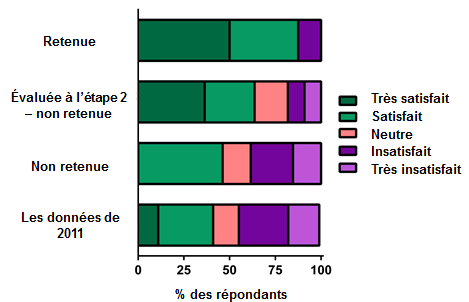

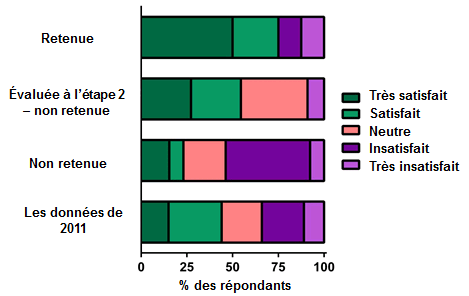

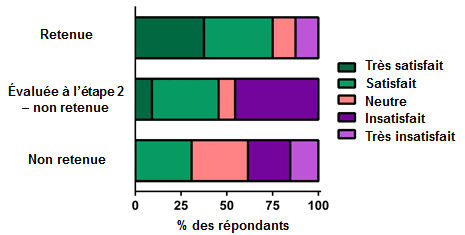

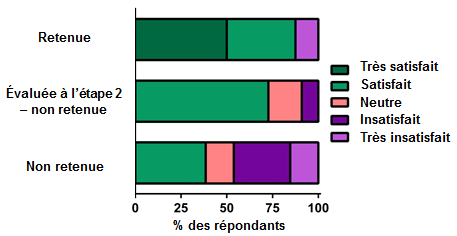

Dans l'ensemble, les évaluateurs des étapes 1 et 2 étaient satisfaits des nouveaux processus d'évaluation. La satisfaction des candidats sur de nombreux points dépendait généralement de leur taux de réussite au concours; ceux qui ont reçu du financement étaient les plus satisfaits, suivis de ceux qui n'ont pas reçu de financement, mais qui ont réussi à l'étape 1, et les candidats les moins satisfaits étaient ceux qui n'ont pas été retenus à l'étape 1.

Limites et orientations futures

Il faut aussi prendre en considération certaines limites de l'étude, en particulier la taille de l'échantillon. Le taux de réponse au sondage était élevé, mais le petit nombre de candidats (n = 75), d'administrateurs de recherche (n = 45) et d'évaluateurs (étape 1 : n = 49; étape 2 : n = 18) limite la fiabilité et la validité de l'analyse finale. À long terme, un échantillon beaucoup plus grand sera examiné dans les nouvelles études.

Dans l'ensemble, les résultats de l'étude révèlent qu'un bon nombre des éléments conceptuels élaborés pour le volet Projet et le volet Fondation ont été bien reçus par les administrateurs de recherche, les candidats et les évaluateurs du concours de Synthèse des connaissances de l'automne 2013. Plusieurs points à améliorer ont été notés par les participants à l'étude. Bon nombre de ces suggestions ont d'ailleurs déjà été prises en compte pour les études pilotes subséquentes.

Introduction

Le succès de la transition vers la nouvelle série de programmes ouverts et le nouveau processus d'évaluation par les pairs repose surtout sur la capacité des IRSC de mettre à l'essai efficacement et effisciemment la fonctionnalité des éléments conceptuels de l'évaluation par les pairs avant leur mise en œuvre complète. Ainsi, les IRSC mettront à l'essai les nouveaux éléments conceptuels (décrits dans le tableau 1 de la section Méthodes ci-dessous) afin de vérifier qu'ils fonctionnent bien, qu'ils permettent de bien présenter les aspects importants des demandes existantes (p. ex. application des connaissances intégrée), que le nouveau processus d'évaluation par les pairs est fiable et juste, et que les nouveaux processus de demande et d'évaluation réduisent à la fois le fardeau imposé aux candidat set aux évaluateurs. Les participants aux concours pilotes (administrateurs de recherche, candidats et évaluateurs) seront sondés à la fin de chacune des étapes des processus de demande et d'évaluation pour chaque concours.

Les résultats des sondages réalisés pour le concours de Synthèse des connaissances de 2013 sont décrits dans le présent rapport. À mesure que les projets pilotes seront terminés, les IRSC prévoient rendre les conclusions accessibles au milieu de la recherche afin de contribuer à l'ensemble de la littérature sur l'évaluation par les pairs et la conception de programmes.

La mise à l'essai des éléments conceptuels de l'évaluation par les pairs permettra aux IRSC d'ajuster et de peaufiner les systèmes et les processus afin de faciliter la tâche aux candidats et aux évaluateurs. Afin de déterminer les aspects à améliorer, les IRSC sondent les candidats, les établissements et les évaluateurs pour obtenir leurs commentaires.

Remarque : Il importe de noter que, durant les concours pilotes, les IRSC s'assureront que la qualité du processus d'évaluation par les pairs n'est pas compromise et que chaque demande fait l'objet d'une évaluation objective, transparente et de haute qualité.

Remarque : Les IRSC utilisent aussi des données issues de ce concours pilote pour analyser le comportement des évaluateurs, notamment en observant le nombre de fois où ils ont modifié leurs évaluations après avoir vu celles de leurs pairs, ont participé à une discussion en ligne asynchrone ou ont modifié le classement des demandes leur ayant été attribuées. Ces analyses sont effectuées séparément, et les résultats seront communiqués ultérieurement.

Aperçu du concours

Le programme de Synthèse des connaissances est un programme ouvert doté d'un élément d'application intégrée des connaissances. Le programme est conçu pour accélérer l'utilisation et l'application des connaissances synthétisées en matière de prise de décision : 1) en soutenant les partenariats entre les chercheurs et les utilisateurs des connaissances afin de produire des examens de la portée et des synthèses qui répondent aux besoins en information des utilisateurs des connaissances dans tous les domaines de la santé et 2) en étendant les avantages de la synthèse des connaissances à de nouvelles questions importantes pour les utilisateurs des connaissances et à des domaines de recherche qui ne font habituellement pas l'objet de synthèses.

Le programme de Synthèse des connaissances a été retenu pour ce pilote étant donné qu'il s'agit d'un programme de subventions de fonctionnement dont de nombreux éléments sont comparables à ceux du Programme ouvert de subventions de fonctionnement (POSF). De plus, il offre un environnement plus contrôlé, étant donné que le nombre de demandes et d'évaluateurs est plus restreint que dans le cas du POSF. Enfin, les demandes peuvent porter sur n'importe lequel des quatre thèmes de recherche des IRSC, soit la recherche biomédicale, la recherche clinique, la recherche sur les services et les politiques de santé, et la recherche sur la santé publique et la santé des populations. Pour ce concours, 79 demandes ont été évaluées par 49 évaluateurs à l'étape 1; les 39 meilleures demandes sont passées à l'étape 2, où elles ont été évaluées par 18 évaluateurs.

Méthodes

Renseignements sur le concours pilote

Dans ce premier concours pilote, un certain nombre d'éléments conceptuels du programme sont demeurés inchangés.Les éléments conceptuels mis à l'essai, présentés dans le tableau 1, sont classés dans l'une ou l'autre des deux grandes catégories suivantes :

- objectifs et critères d'admissibilité du programme

- processus d'assignation des demandes aux évaluateurs

| Élément conceptuel | Objectifs | Description |

| Demande et évaluation structurées (nouveaux critères de sélection) |

|

|

| Augmentation du nombre d'évaluateurs par demande (5 évaluateurs/ demande, tant à l'étape 1 qu'à l'étape 2) |

|

|

Évaluation en plusieurs étapes |

|

|

Évaluation à distance et discussion en ligne |

|

|

Nouvelle échelle de cotation et nouveau système de classement |

|

|

Réunion en personne |

|

|

Remarque : La qualité des évaluations individuelles n'a pas été évaluée dans ce projet pilote.

Méthode de sondage

Les sondages visaient à évaluer la perception et l'expérience des participants relativement au processus d'évaluation par les pairs et aux éléments conceptuels mis à l'essai. Ils ont été conçus à l'aide du logiciel en ligne Fluid Surveys; quatre sondages correspondant à chacune des étapes du concours pilote ont été créés. Aux fins de la présente analyse, ils ont été divisés en quatre étapes :

- Soumission des demandes

- Sondage auprès des candidats

- Sondage auprès des administrateurs de recherche

- Étape 1 de l'évaluation

- Sondage auprès des évaluateurs à l'étape 1

- Étape 2 de l'évaluation

- Sondage auprès des évaluateurs à l'étape 2

- Réception des résultats du concours

- Sondage auprès des candidats

Les candidats et les administrateurs de recherche ont été sondés après la présentation des demandes aux IRSC. Ce premier sondage portait sur la perception et l'expérience des candidats à l'égard du nouveau processus de demande structurée, des nouveaux critères de sélection (les critères de sélection permettent-ils de présenter efficacement les éléments d'application des connaissances intégrée?) et du formulaire de demande structurée (les limites de caractères, notamment).

Les évaluateurs à l'étape 1 ont été sondés à la suite de la présentation de leurs évaluations aux IRSC. Ce sondage portait sur la perception et l'expérience des évaluateurs à l'égard du processus d'évaluation structurée à l'étape 1, de la charge de travail des évaluateurs, du formulaire de demande structurée (notamment la valeur des pièces jointes admissibles), de nouveaux critères de sélection (les éléments d'application des connaissances intégrée peuvent-ils être capturés efficacement à l'aide des critères de sélection?) et de différents éléments du processus d'évaluation à l'étape 1 (échelle de sélection, feuille de sélection, processus de cotation et de classement et discussion en ligne).

Les évaluateurs à l'étape 2 ont été sondés à la suite de la réunion en personne du comité. Ce sondage portait sur la perception et l'expérience des évaluateurs à l'égard de l'étape 2 du processus d'évaluation, de la charge de travail des évaluateurs, de la qualité des évaluations à l'étape 1, des activités préalables à la réunion (lecture des commentaires des évaluateurs et processus de catégorisation, notamment)et de divers aspects de la réunion en personne (validation de la liste de demandes, processus de vote et utilisation du seuil de financement).

Les candidats ont été sondés à nouveau après réception des résultats du concours. Ce dernier sondage portait sur leur perception et leur expérience quant au processus d'évaluation structurée (étape 1 et étape 2), la qualité des évaluations reçues, et leur satisfaction globale à l'égard du processus d'évaluation.

Les données présentées dans ce rapport comprennent les réponses de l'ensemble des sondages, terminés ou non.

Limites

Il est important de prendre note des limites de ce concours pilote.

Généralisation : Le programme de Synthèse des connaissances est un programme de subventions de fonctionnement; il existe toutefois certaines différences notables dans sa conception comparativement à celle des autres programmes ouverts de subventions (p. ex. le POSF). Notamment, le programme nécessite une approche axée sur les utilisateurs des connaissances et l'application des connaissances intégrée. En outre, la majorité des demandes reçues dans le cadre de ce programme correspondent aux thèmes 3 et 4. Ces divers facteurs pourraient limiter la généralisation des résultats.

Projet pilote non-aveugle : Les réponses aux sondages pourraient être influencées par le fait que les participants savaient qu'ils participaient à une expérience et que certains d'entre eux faisaient une demande de financement aux IRSC.

Taille de l'échantillon : Malgré le taux de réponse élevé aux sondages, et supérieur aux objectifs, le faible nombre de candidats, d'administrateurs de recherche et d'évaluateurs limitera l'analyse statistique possible. Avec le temps, un échantillon beaucoup plus vaste pourra être utilisé. Entre-temps, la petite taille de l'échantillon devrait être prise en compte en interprétant les résultats présentés.

Quoi qu'il en soit, les résultats du premier sondage sont positifs dans le contexte de ce concours. Les répondants ont indiqué un certain nombre d'aspects à améliorer, et plusieurs des améliorations suggérées ont été apportées dès les projets pilotes suivants.

Résumé des résultats

Les résultats de cette étude indiquent que dans l'ensemble, la majorité des candidats et des évaluateurs considèrent que les nouveaux processus de demande et d'évaluation par les pairsmis à l'essai sont équivalents aux processus actuels et/ou aussi satisfaisants. De plus, selon eux, de nombreuses modifications et mises à jour peuvent être apportées aux éléments conceptuels pour améliorer l'expérience des participants aux futurs concours pilotes en ce qui concerne le processus de demande ou d'évaluation.

Les résultats de ce concours pilote sont résumés dans les prochaines sections, qui traitent des aspects suivants :

- l'efficacité du processus de demande structurée;

- l'impact sur la charge de travail des évaluateurs;

- la clarté des critères et de l'échelle de sélection;

- l'efficacité du processus d'évaluation structurée;

- l'expérience de RechercheNet;

- la satisfaction globale à l'égard de la structure du volet Projet.

La description des participants (données démographiques sur les participants au sondage) figure à l'annexe 1. Les résultats détaillés du sondage sont présentés à l'annexe 2.

1. Efficacité du processus de demande structurée

La présente section porte sur l'expérience des candidats et des administrateurs de recherche quant au nouveau processus de demande structurée et aux éléments conceptuels du volet Projet.

Impression globale du nouveau processus de demande structurée

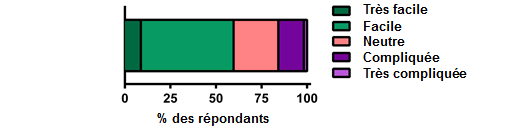

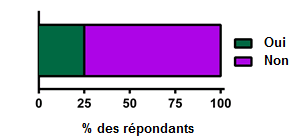

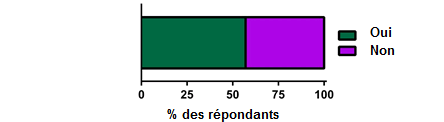

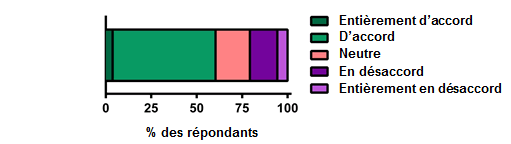

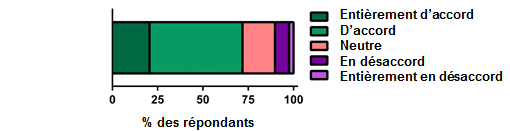

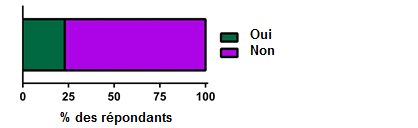

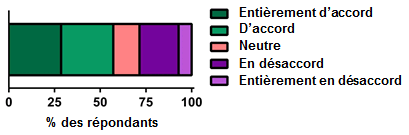

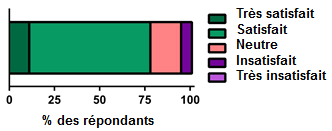

Globalement, une faible majorité de candidats ont trouvé le formulaire de demande structurée facile à utiliser. Selon une faible majorité de candidats et d'administrateurs de recherche, le formulaire de demande structurée est intuitif et facile à utiliser, et le processus de demande structurée est relativement satisfaisant (voir figure 1).

Les candidats et les administrateurs de recherche ont fait des commentaires sur le formulaire de demande structurée; bon nombre d'entre eux ont indiqué qu'il était facile à utiliser. Parmi les problèmes soulevés par les candidats, la demande structurée limiterait l'expression des idées et gênerait le fil narratifjugé essentiel par les candidats dans les propositions. Les limites quant au formatage dans RechercheNet seraient aussi un problème (voir tableau 1).

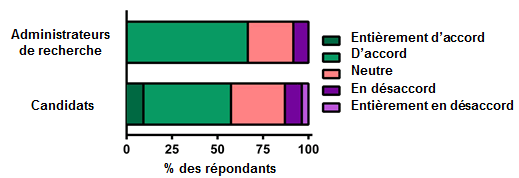

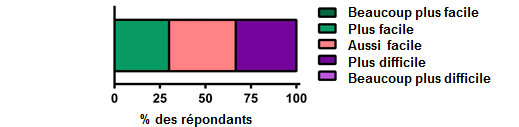

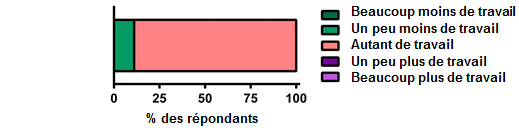

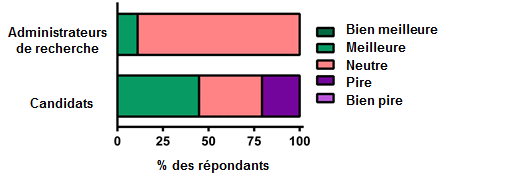

On a demandé aux répondants qui avaient déjà présenté une demande dans le cadre d'un concours de Synthèse des connaissances de comparer leur expérience avec le nouveau processus de demande structurée à leurs expériences passées (voir figure 2). Selon la majorité des répondants, la demande structurée représentait environ le même travail, mais les avis concernant la facilité d'utilisation étaient partagés. En effet, environ un tiers des candidats ont indiqué que le formulaire de demande structurée était plus facile à utiliser que le formulaire précédent, un autre tiers a indiqué que l'expérience demeurait la même, et le dernier tiers considérait que le nouveau formulaire était plus difficile à utiliser. Dans l'ensemble, les candidats ont trouvé le processus de présentation aussi satisfaisant que celui des concours précédents, voire meilleur, tandis que la majorité des administrateurs de recherche ont indiqué ne voir aucune différence par rapport aux concours précédents (voir figure 2).

Chez les candidats qui présentaient à nouveau une demande déjà présentée dans le cadre d'unconcours précédent de Synthèse des connaissances, le fait de devoir adapter la demande pour la faire cadrer dans les limites du formulaire de demande structurée constituait un problème important. La section « Approche » était particulièrement problématique, étant donné que l'espace accordé pour donner les mêmes renseignements concernant la méthodologie avait été considérablement réduit. La section « Budget » posait aussi problème : selon certains candidats, l'espace fourni était insuffisant pour justifier adéquatement les dépenses (voir tableau 2).

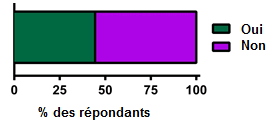

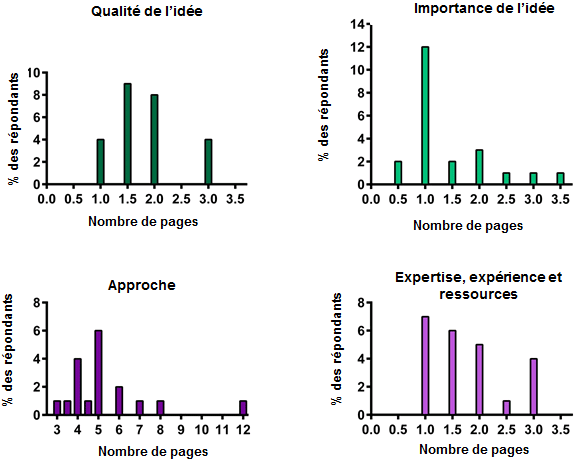

Limites de caractères dans le formulaire de demande structurée

Des limites de caractères ont été fixées dans chaque section du formulaire de demande structurée. On a demandé aux candidats d'indiquer si ces limites permettaient de répondre adéquatement à tous les critères de sélection. Plus de 50 % ont dit ne pas avoir assez d'espace pour donner tous les renseignements pertinents (voir figure 3A). Les réponses des candidats variaient grandement concernant le nombre limite de pages idéal; cependant, le total des réponses indiquées pour chacune des sections donnait en moyenne environ 11 pages, soit la même longueur que le formulaire précédent (voir figure 3B).

Au début, il y a eu confusion quant aux limites de caractères : de nombreux candidats ignoraient que celles-ci comprenaient les espaces, ce qui a engendré beaucoup de frustration. Les candidats se sont vus forcés de supprimer des caractères au moment d'insérer leur texte dans le formulaire de demande structurée dans RechercheNet. Dans l'ensemble, les candidats ont dit qu'ils s'accommoderaient des limites imposées dans la demande structurée, si les évaluateurs acceptaient eux aussi moins de détails dans la demande (voir tableau 3).

La grande majorité des évaluateurs à l'étape 1 étaient d'avis que les limites de caractères fixées dans le formulaire de demande structurée permettaient aux candidats de fournir tous les renseignements pertinents à la demande de subvention (voir figure 4). Il convient toutefois de souligner que dans leurs commentaires aux candidats, certains évaluateurs ont mentionné que leur demande n'était pas suffisamment détaillée. Il se pourrait donc que certains candidats ne soient pas arrivés à inclure des renseignements pertinents dans leur demande aussi habilement que d'autres, ou encore que les limites ne leur aient pas permis de fournir tous les détails auxquels s'attendaient les évaluateurs. Cette différence sera évaluée lors de prochains concours pilotes.

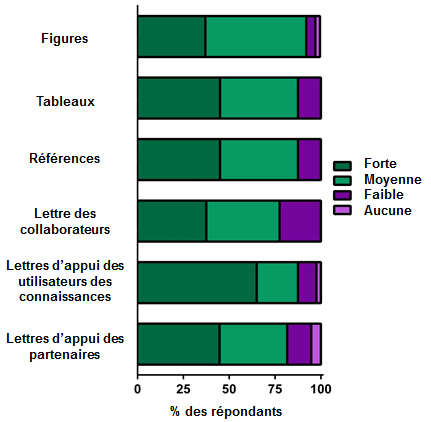

Utilité des pièces jointes admissiblespour lesévaluateurs à l'étape 1

Dans le nouveau formulaire de demande structurée, les candidats ne pouvaient joindre que certains éléments (figures, tableaux, références, CV, lettres de collaboration et lettres d'appui d'utilisateurs des connaissances ou de partenaires). Dans l'ensemble, toutes les pièces jointes admissible sont été jugées très utiles ou moyennement utiles par les évaluateurs (voir figure 5A). Certains évaluateurs étaient d'avis que les IRSC ne devraient imposer aucune limite quant au type de pièces jointes admissibles; d'autres ont indiqué que certaines pièces jointes concernant la méthodologie devraient être admissibles (stratégies de recherche, recherches pilotes, protocole d'évaluation, etc.) étant donné qu'il est difficile d'évaluer une demande de subvention de Synthèse des connaissances sans avoir accès à ces renseignements. Enfin, certains évaluateurs ont proposé de restreindre le nombre de lettres d'appui et d'accepter les plus pertinentes ou les plus éloquentes seulement pour réduire leur charge de travail (voir tableau 4).

Utilité du CV académique et du CV d'utilisateur des connaissances des IRSC

Les évaluateurs à l'étape 1 ont trouvé certains aspects du CV utiles lors de leurs évaluations, soitles sections sur les antécédents de financement, les publications, l'application des connaissances et de la technologie, les collaborations internationales et la présentation. La majorité des évaluateurs jugeaient appropriées les limites fixées dans le CV (voir figure 5B). Certain sont indiqué que le format uniforme des CV était utile, mais que la présentation gagnerait à être améliorée (voir tableau 5).

Difficultés éprouvées dans la demande structurée

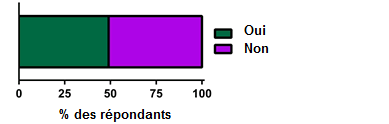

Les candidats ont eu l'occasion d'informer les IRSC de problèmes non techniques survenus durant le processus de demande structurée. Seul le quart des candidats ont dit avoir eu des difficultés en remplissant leur demande (voir figure 6).

La plupart des difficultés avaient trait aux limites de caractères jugées trop contraignantes, en particulier par les candidats qui ignoraient que ces limites comprenaient les espaces (voir tableau 5). En outre, les candidats étaient d'avis qu'il devrait être possible d'intégrer des images dans le formulaire de demande structurée dans RechercheNet. De plus, ils ont mentionné certains problèmes de formatage dans le formulaire de demande structurée et le fichier PDF généré (absence de couleurs, disparition aléatoire d'espaces, soulignement trop foncé, etc.).

2. Impact sur la charge de travail des évaluateurs

Dans cette section, il sera question de l'expérience des évaluateurs concernant la charge de travail à l'étape 1 et à l'étape 2.

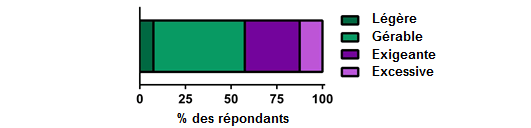

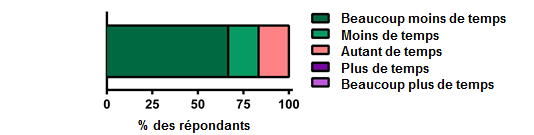

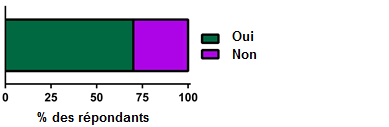

Charge de travail des évaluateurs à l'étape 1

Dans l'ensemble, la majorité des évaluateurs à l'étape 1ont indiqué que leur charge de travail était gérable ou difficile à gérer (voir figure 7A). Les évaluateurs devaient estimer le temps consacré à diverses activités d'évaluation; ces chiffres ont ensuite été comparés à ceux recueillis auprès des évaluateurs à la suite du concours de Synthèse des connaissances du printemps 2013 (voir figure 7B et tableau 6). Comparativement à ces derniers, les évaluateurs à l'étape 1 ont à la fois mis moins de temps à lire (1,53+/-0,14 heure pour les évaluateurs à l'étape 1, comparativement à 2,21+/-0,25 heures pour les évaluateurs du printemps 2013) et à évaluer par écrit une seule demande (0,95+/-0,12 heure pour les évaluateurs à l'étape 1 comparativement à 1,66+/-0,23 heure pour les évaluateurs du printemps 2013). Cette diminution du temps consacré à certaines activités d'évaluation est encourageante; elle sera suivie continuellement durant les concours pilotes du volet Projet. Aucun calcul n'a été fait pour étudier les différences significatives quant au temps nécessaire pour procéder à l'évaluation des demandes, et aucune comparaison n'a été faite quant à la charge de travail des évaluateurs et au nombre de demandes attribuées, étant donné que l'utilité et la comparabilité de ces données préliminaires sont encore limitées.

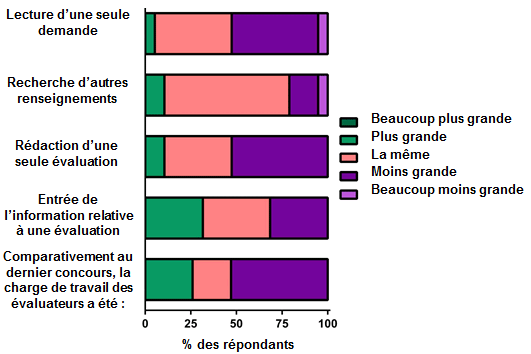

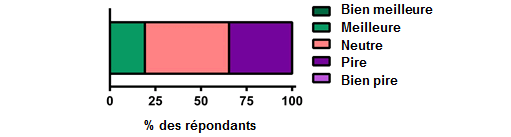

Parmi les évaluateurs qui avaient déjà évalué des demandes lors d'un concours de Synthèse des connaissances, un peu plus de 50 % ont indiqué que la charge de travail était moins élevée durant le concours pilote, et seulement 25 % considéraient qu'il y avait plus de travail (voir figure 7C). Comparativement à une expérience précédente d'évaluation, les évaluateurs ont trouvé que la saisie de l'information relative à l'évaluation dans Recherche Net et la recherche en ligne de renseignements supplémentaires sur les demandes représentaient environ le même temps de travail. En outre, cette cohorte d'évaluateurs trouvait qu'en moyenne, la lecture et l'évaluation par écrit des demandes étaient moins exigeantes.

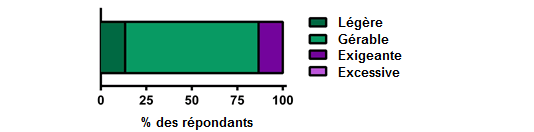

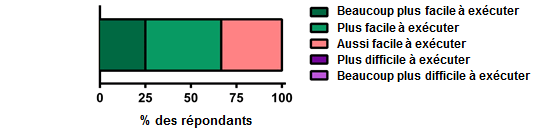

Charge de travail des évaluateurs à l'étape 2

La majorité des évaluateurs à l'étape 2ont indiqué que leur charge de travail était légère ou gérable (voir figure 8A). Parmi les évaluateurs qui avaient évalué des demandes lors d'un concours précédent de Synthèse des connaissances, plus de 80 % ont indiqué que la charge de travail dans le concours pilote était moindre comparativement à un concours précédent (voir figure 8B). En la comparant à des expériences antérieures d'évaluation, les évaluateurs ont trouvé que l'étape 2 du processus d'évaluation était plus facile ou aussi facile que celle de concours précédents (voir figure 8C). De plus, comparativement aux concours précédents de Synthèse des connaissances, les évaluateurs ont trouvé les demandes plus concises et plus assimilables (voir tableaux 7 et 8).

En tenant seulement compte de la réunion en personne du comité, le temps consacré aux réunions comparativement aux concours précédents de Synthèse des connaissances était significativement moins long. C'est donc dire que les évaluateurs à l'étape 2 ont passé beaucoup moins de temps à discuter des demandes lors de la réunion en personne du comité que les évaluateurs qui ont participé au concours de Synthèse des connaissances du printemps 2013 (voir figure 8D). Cette diminution pourrait s'expliquer par la nouvelle étape 2 du processus d'évaluation, qui permet d'aborder à la réunion seulement les demandes se trouvant près du seuil de financement.

Les évaluateurs à l'étape 2 ont formulé de nombreuses suggestions sur l'étape 2 du processus d'évaluation, dont certaines pourraient contribuer à réduire davantage le fardeau des évaluateurs si elles étaient mises en œuvre. Les évaluateurs à l'étape 2 hésitaient à effectuer leur évaluation sans se référer à la demande, d'autant plus qu'ils ne connaissaient pas le parcours professionnel des évaluateurs à l'étape 1. Ils ont indiqué qu'ils pourraient se sentir moins obligés de consulter systématiquement les documents relatifs à la demande s'ils connaissaient l'identité des évaluateurs à l'étape 1. En fait, connaître le nom et le parcours de l'évaluateur à l'étape 1 pourrait atténuer la deuxième raison pour laquelle les évaluateurs à l'étape 2se sentaient contraints de consulter les documents relatifs à la demande, soit la qualité des évaluations à l'étape 1. En effet, de nombreux évaluateurs à l'étape 2ont indiqué que les commentaires reçus des évaluateurs à l'étape 1ne suffisaient souvent pas à justifier la cote attribuée (A-E) ou n'étaient pas vraiment utiles. Dans ces cas, la décision responsable des évaluateurs à l'étape 2consistait à réévaluer les documents relatifs à la demande, ce qui a prolongé leur temps d'évaluation. La qualité des évaluations écrites à l'étape 1 pourrait être améliorée si l'on indiquait aux évaluateurs à l'étape 1que la consignation des forces et des faiblesses liées à chaque critère de sélection vise principalement à justifier les cotes attribuées, et que ces justifications servent non seulement aux candidats, mais aussi aux évaluateurs à l'étape 2, qui ont pour tâche de consolider les cinq évaluations de chaque demande et de prendre une décision relative au financement en fonction de ces évaluations (voir tableaux 7, 8 et 19).

3. Clarté des critères et de l'échelle de sélection

Dans cette section, il sera question de l'expérience des évaluateurs relativement aux critères et à l'échelle de sélection des évaluateurs à l'étape 1 et à l'étape 2.

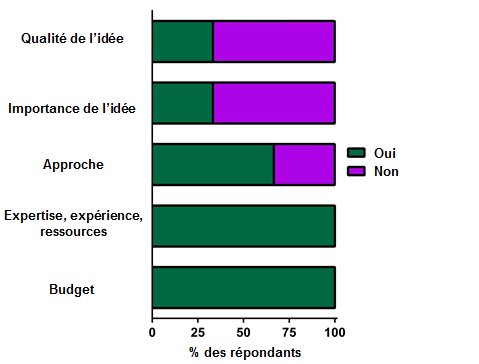

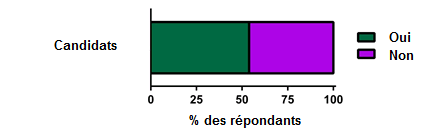

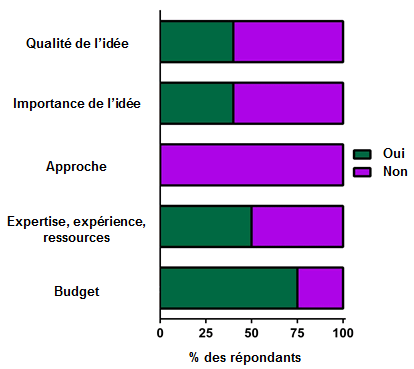

Critères de sélection

Les nouveaux critères de sélection comportent la difficulté suivante : la distinction entre les critères « Qualité de l'idée » et « Importance de l'idée » ne serait pas claire pour les candidats. Dans le sondage, on a demandé aux candidats et aux évaluateurs à l'étape 1 si la distinction entre les deux critères de sélection était évidente pour eux au moment de préparer ou d'évaluer les demandes. Environ la moitié des candidats sondés ont indiqué que la distinction n'était pas claire (voir figure 9). Les évaluateurs à l'étape 1 ont également eu du mal à faire la différence entre la qualité et l'importance de l'idée, et selon eux, il était évident qu'il en était de même pour les candidats, étant donné que l'information fournie aux évaluateurs dans les deux sections était semblable et répétitive. La principale suggestion formulée tant par les candidats que les évaluateurs consiste à combiner les deux critères. Certains évaluateur sont mentionné que le guide d'interprétation des critères était utile pour percevoir la distinction entre la qualité et l'importance de l'idée; d'autres ont toutefois indiqué que malgré l'utilité du document, les termes et formulations qu'on y trouve ne sont pas intuitifs, étant donné que les chevauchements sont nombreux dans les descriptions des deux critères (voir tableau 9).

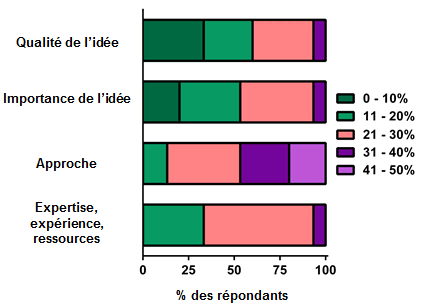

Actuellement, les critères de sélection sont pondérés de façon égale (25 % par critère). Les évaluateurs à l'étape 1 ne s'entendaient pas pour dire si la pondération des critères de sélection devrait être égale. Lorsqu'on leur a demandé quelle serait la pondération idéale, la majorité des évaluateurs en désaccord avec la pondération actuelle ont fait valoir qu'il faudrait accorder une plus grande pondération à la section « Approche », aux dépens des sections « Qualité de l'idée » et « Importance de l'idée », alléguant surtout que si un projet n'est pas solide sur le plan méthodologique, l'idée derrière ce projet, aussi importante et intéressante soit-elle, ne sera pas convaincante, puisque le projet ne parviendra pas à répondre à la question (voir figure 10 et tableau 10).

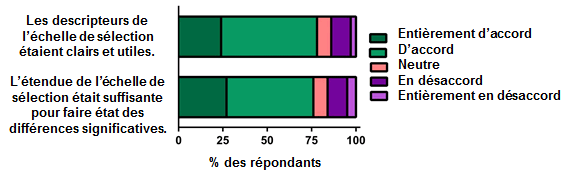

Échelle de sélection

La majorité des évaluateurs à l'étape 1ont indiqué que les descripteurs de l'échelle de sélection (A-E) étaient compréhensibles et utiles. De plus, selon eux, l'échelle de sélection était suffisamment large pour que des différences significatives soient mises en évidence entre les demandes (voir figure 11).

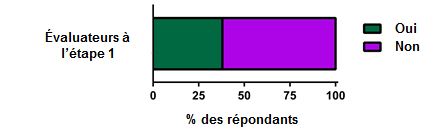

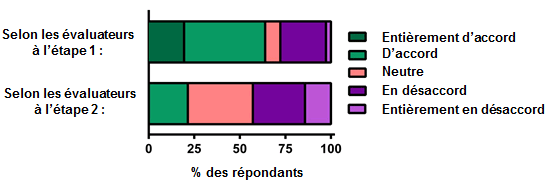

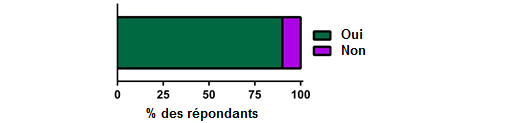

On a demandé aux évaluateurs à l'étape 1 s'ils avaient eu recours à toute l'étendue de l'échelle de sélection (A-E). En majorité, ils ont indiqué l'avoir fait. Or, lorsqu'on a demandé aux évaluateurs à l'étape 2 si les évaluateurs à l'étape 1 avaient eu recours à toute l'étendue de l'échelle de sélection, moins de 25 % ont indiqué que c'était le cas (voir figure 12A). Il importe de noter que sur un total de 79 demandes, on a attribué les 39 meilleures aux évaluateurs à l'étape 2, ce qui a sans doute influé sur les réponses à cette question. Pour déterminer de façon empirique si toute l'étendue de l'échelle de sélection a été utilisée, nous avons fait le compte des cotes attribuées (A-E), puis calculé le pourcentage de chacune. La majorité des cotes attribuées (73,45 %) étaient dans le haut de l'échelle: soit 36,01% de A et 37,44 % de B (en moyenne dans l'ensemble des critères de sélection) (voir figure 12B).

L'usage des lettres A à E aurait un peu trop rappelé les cotes attribuées à l'école; les évaluateurs à l'étape 1ont d'ailleurs eu du mal à attribuer beaucoup de cotes inférieures à B. En effet, certains d'entre eux ont indiqué avoir eu de la difficulté à recourir à la moitié inférieure de l'échelle, soit parce que les demandes ne répondaient pas aux critères des cotes C, D ou E, soit parce que les critères ne permettaient pas de rendre compte de différences plus subtiles entre les demandes (il existe cinq critères : les évaluateurs considèrent donc que des écarts de 20 % les séparent, ce qui est trop grand pour tenir compte de différences plus subtiles). En revanche, selon certains évaluateurs, l'échelle pourrait être raccourcie d'une ou deux lettres, par exemple ABC ou ABCD. D'autres ont indiqué qu'il était difficile de faire la distinction entre les différentes lettres, puisqu'elles ne faisaient pas référence aux critères de sélection. Dans le cas présent, il se pourrait que les évaluateurs aient avantage à ce qu'on leur présente des exemples de situations dans lesquelles les différentes cotes devraient être attribuées (voir tableau 11).

L'attribution de cotes pour chaque critère de sélection vise notamment à orienter le processus de classement. C'est pourquoi il est important que les évaluateurs à l'étape 1soient en mesure de comparer efficacement la qualité des différentes demandes. Dans d'autres commentaires, les évaluateurs à l'étape 1 et à l'étape 2 ont suggéré qu'il pourrait être avantageux de subdiviser le haut de l'échelle (p. ex. entre les cotes A et B). Ils ont aussi proposé de changer les lettres, et même d'éviter complètement d'utiliser des cotes alphabétiques .Les IRSC prendront ces suggestions en considération en prévision des concours à venir (voir tableau 11).

Application des connaissances intégrée

Un élément important de ce concours pilote consistait à s'assurer que le nouveau processus de demande structurée et les nouveaux critères de sélection permettraient de présenter adéquatement les éléments essentiels d'une approche d'application des connaissances intégrée.

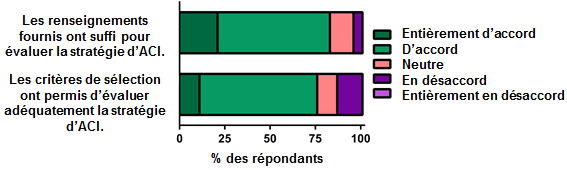

Une faible majorité de candidats ont indiqué que, globalement, les critères de sélection leur avaient permis de présenter adéquatement dans la demande structurée leur approche d'application des connaissances intégrée (voir figure 14A). Environ le tiers des candidats qui avaient déjà présenté une demande dans le cadre d'un concours de Synthèse des connaissances ont indiqué que les critères de sélection et la demande structurée compliquaient l'inclusion de l'approche d'application des connaissances intégrée; toutefois, selon les deux tiers d'entre eux, l'inclusion de l'approche dans leurs demandes structurées était semblable, voire plus facile (voir figure 14B).

Les candidats ont fait part de certaines préoccupations concernant l'application des connaissances (AC) : en effet, l'endroit où présenter les renseignements à ce sujet n'était pas clair, et il manquait d'espace dans les différentes sections de la demande structurée pour présenter l'approche d'AC. De nombreux candidats ont suggéré qu'une section distincte sur l'approche d'AC intégrée soit créée dans la demande structurée. Il importe aussi de souligner que certains candidats ont eu l'impression que l'AC était devenue moins importante pour les IRSC, étant donné que les renseignements concernant l'approche d'AC étaient dissimulés dans le formulaire de demande structurée (voir tableau 12).

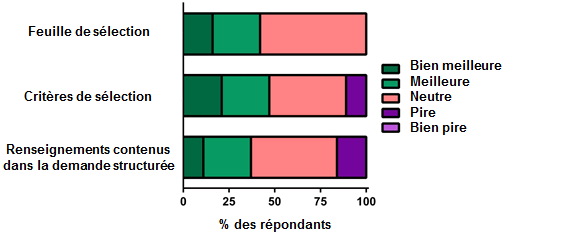

La majorité des évaluateurs étaient d'avis que l'information fournie par les candidats suffisait à évaluer l'approche d'AC intégrée et que les critères de sélection permettaient aux évaluateurs d'évaluer adéquatement cette dernière (voir figure 15A). La majorité des évaluateurs qui avaient déjà évalué des demandes dans le cadre d'un concours de Synthèse des connaissances ont indiqué que la feuille de sélection, les critères de sélection et l'information fournie par les candidats dans la demande structurée n'avaient eu aucune incidence sur l'évaluation de l'approche d'AC intégrée et la formulation de commentaires aux candidats à ce sujet, ou avaient simplifié le processus (voir figure 15B). Certains évaluateurs auraient aimé qu'une section distincte soit réservée à l'AC, étant donné que cette information pouvait être présentée dans plusieurs sections de la demande ou des critères de sélection, ce qui leur a compliqué la tâche (voir tableau 13).

4. Efficacité du processus d'évaluation structurée

Dans cette section, il sera question de l'expérience des évaluateurs à l'étape 1 et à l'étape 2 quant au nouveau processus d'évaluation structurée et aux éléments conceptuels du volet Projet.

Étape 1 de l'évaluation

Feuille de sélection

Pour chacune des sections de la demande, les évaluateurs à l'étape 1 devaient attribuer une cote, indiquer les forces et les faiblesses, et justifier la cote attribuée à l'aide de la feuille de sélection dans RechercheNet. Les évaluateurs à l'étape 1 ont, dans l'ensemble, trouvé la feuille de sélection conviviale (voir figure 16A). Les IRSC ont fixé une limite de caractères dans celle-ci (1 750 caractères pour les forces et 1 750 caractères pour les faiblesses dans chaque section). La majorité des évaluateurs ont indiqué que cette limite était suffisante pour faire aux candidats des commentaires adéquats (voir figure 16B); cependant, selon les autres, jusqu'à trois pages devraient être allouées pour rédiger les commentaires relatifs à la section « Approche », jugée particulièrement problématique (voir figure 16C et tableau 14). En fait, certains évaluateurs ont dû se servir d'autres sections où ils n'avaient pas atteint la limite de caractères (p. ex. la section « Budget ») pour compléter les commentaires sur la section « Approche ». Certains évaluateurs ont trouvé difficile et répétitif de devoir indiquer les forces et les faiblesses liées à chaque critère; ils auraient préféré donner une justification pour chaque cote, puis une appréciation globale des forces et des faiblesses de la demande dans son ensemble. De plus, selon certains évaluateurs, leurs commentaires ne devraient faire l'objet d'aucune limite de caractères. D'autres, plus nuancés, ont proposé le recours à une limite globale de caractères pour l'ensemble des sections (plutôt qu'une limite par section), étant donné qu'il se pourrait qu'une section nécessite plus de commentaires qu'une autre (voir tableau 15).

Lecture des évaluations préliminaires

Étant donné que les évaluateurs à l'étape 1 ne se rencontrent pas en personne, les IRSC ont mis en place un processus leur permettant de lire les évaluations préliminaires des autres évaluateurs travaillant sur la même demande. Ce sont moins de 50 % des évaluateurs qui l'ont fait (voir figure 17A) et, souvent, le fait de lire les évaluations préliminaires ne les a pas influencés dans leurs propres évaluations (voir figure 17B). La majorité des évaluateurs ont indiqué ne pas avoir lu les évaluations préliminaires parce qu'ils n'avaient pas eu le temps de le faire ou parce qu'elles n'avaient pas été soumises à temps aux IRSC (voir tableau 16). D'autres évaluateurs ont indiqué ne pas vouloir être influencés par leurs pairs ou encore ne pas savoir comment accéder à ces évaluations préliminaires. Les évaluateurs qui ont lu les évaluations préliminaires d'autres évaluateurs y ont consacré jusqu'à deux heures.

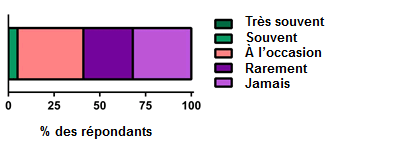

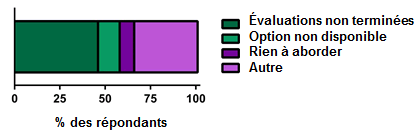

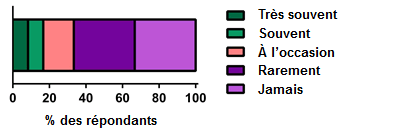

Discussion en ligne

Étant donné qu'il n'y a aucune réunion en personne pour les évaluateurs à l'étape 1, les IRSC ont mis en place un outil de discussion en ligne asynchrone permettant aux évaluateurs de communiquer avec leurs pairs évaluant la même demande. Ce sont environ 25 % des évaluateurs qui ont pris part à une discussion en ligne (voir figure 18A). Les principales raisons évoquées par les évaluateurs n'ayant pas pris part aux discussions sont les suivantes : les évaluations n'avaient pas été terminées à temps, ils n'avaient pas le temps, aucune discussion n'avait été initiée, ou encore il n'y avait aucun sujet de discussion à aborder (voir figure 18B et tableau 17).

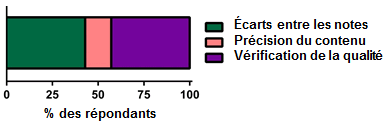

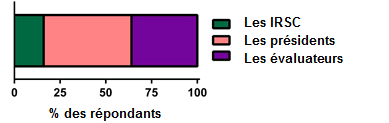

Sur les dix évaluateurs qui ont pris part à une discussion en ligne, sept les ont engagées (voir figure 19A). De ce nombre, trois discussions ont été amorcées pour discuter d'écarts entre les cotes, trois autres pour vérifier la qualité d'évaluations, et la dernière, à des fins de précision du contenu (voir figure 19B). Les évaluateurs à l'étape 1 ont indiqué qu'un président virtuel ou les évaluateurs (à leur discrétion) devaient amorcer la discussion en ligne (voir figure 19C), et que des critères précis devraient être utilisés pour décider quand une discussion en ligne doit avoir lieu (voir figure 19D). La plupart des évaluateurs croient qu'une discussion en ligne doit être créée lorsqu'il y a des écarts importants entre les cotes ou les commentaires (voir tableau 18).

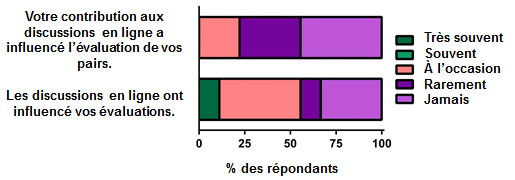

Selon les évaluateurs qui ont pris part à une discussion en ligne, leur contribution n'avait eu aucune incidence sur l'évaluation des autres évaluateurs; or, plus de 50 % ont indiqué que leurs discussions en ligne avec d'autres évaluateurs avaient souvent ou occasionnellement influé sur leurs propres évaluations (voir figure 20).

Évaluations de l'étape 1 (par les évaluateurs à l'étape 2)

À l'étape 2 du processus d'évaluation, les évaluateurs doivent lire les cotes attribuées et les commentaires formulés par les évaluateurs à l'étape 1, puis consolider ces cinq évaluations. Pour ce faire, il est primordial que les documents liés à l'étape 1 de l'évaluation soient de grande qualité.

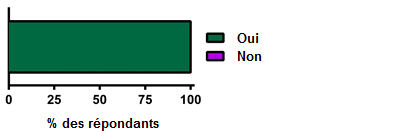

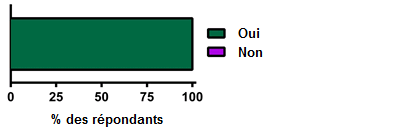

Durant ce concours, 100 % des évaluateurs ont consulté les demandes et les évaluations de l'étape 1 de chacune des demandes leur étant attribuées (voir figure 22A). Moins de 50 % des évaluateurs ont trouvé que les évaluateurs à l'étape 1 avaient fourni des justifications claires pour appuyer les cotes qu'ils avaient attribuées (voir figure 21). Cette statistique est préoccupante, étant donné que les évaluateurs à l'étape 2 se sentiront obligés de continuer à examiner les demandes en plus des évaluations de l'étape 1 tant que leur qualité ne se sera pas considérablement améliorée. C'est probablement pourquoi selon plus de 50 % des évaluateurs à l'étape 2, il est essentiel de lire tant la demande que les évaluations de l'étape 1 pour évaluer adéquatement une demande (voir figure 22B). La majorité des critiques formulées par les évaluateurs à l'étape 2 portaient sur les justifications insuffisantes des évaluateurs à l'étape 1 quant aux cotes qu'ils avaient attribuées (comme s'ils ignoraient que d'autres évaluateurs se baseraient sur leurs commentaires pour faire des recommandations relatives au financement) et le fait que les évaluateurs à l'étape 1 n'ont pas recouru à toute l'étendue de l'échelle de sélection, ce qui a compliqué l'interprétation de différences subtiles entre les demandes (voir tableau 19).

Étape 2 de l'évaluation

Examendes évaluations de l'étape 1

Lors du concours de Synthèse des connaissances de l'automne 2013, chaque évaluateur à l'étape 2 a reçu 12 ou 13 demandes à évaluer. Comme il a été mentionné précédemment, chacun devait lire les évaluations de l'étape 1 pour faire des recommandations relatives au financement. En outre, chacun avait accès aux documents relatifs à la demande et pouvait consulter les demandes au besoin. Résultat intéressant issu du concours pilote : les évaluateurs à l'étape 2 étaient très réticents à prendre des décisions concernant les demandes qu'on leur avait attribuées sans consulter eux-mêmes les demandes. En effet, l'ensemble des évaluateurs à l'étape 2 a consulté les demandes en plus des évaluations de l'étape 1 (voir figure 22A). De surcroît, plus de 50 % des évaluateurs à l'étape 2 croyaient qu'ils devaient lire les documents relatifs à la demande et les évaluations de l'étape 1 (voir figure 22B).

Il est concevable que les évaluateurs à l'étape 2 ne se sentent pas à l'aise de se fier uniquement aux évaluations de l'étape 1 pour prendre leurs décisions. Par ailleurs, ces évaluateurs ont dit qu'il en serait autrement s'ils savaient en quoi consistent la formation et l'expérience des évaluateurs (voir tableau 19). La communication de cette information et le recours à d'autres méthodes visant à faciliter la transition vers le nouveau processus d'évaluation pour les évaluateurs à l'étape 2 seront envisagés dans le cadre de futurs concours pilotes.

Afin d'assurer le bon déroulement du nouveau processus, les évaluations à l'étape 1 doivent toujours être d'une grande qualité. Pour ce faire, les évaluateurs à l'étape 1 doivent clairement justifier les cotes qu'ils attribuent, faire référence aux parties pertinentes de la demande et indiquer s'ils sont réticents à évaluer certains aspects d'une demande en raison de connaissances insuffisantes. Ainsi, les évaluateurs à l'étape 2 pourront prendre des décisions éclairées quant à la qualité globale de chaque demande. Comme il est mentionné dans la section précédente, de nombreux évaluateurs à l'étape 2 ont trouvé que les commentaires de leurs pairs à l'étape 1 étaient très peu nombreux ou ne suffisaient pas pour justifier les cotes attribuées. En outre, comme l'échelle de sélection n'a pas été utilisée dans toute son étendue par les évaluateurs à l'étape 1, de nombreuses demandes ont obtenu la cote A ou B, ce qui fait qu'il était très difficile de différencier les demandes de grande qualité et de qualité moyenne (voir tableau 19). Il a déjà été question des méthodes qui permettraient à la fois d'améliorer la qualité des commentaires des évaluateurs à l'étape 1 et d'encourager ces derniers à recourir à toute l'étendue de l'échelle de sélection; comme nous pouvons le constater, ces méthodes sont essentielles à l'efficacité de l'étape 2 du processus d'évaluation.

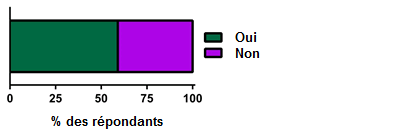

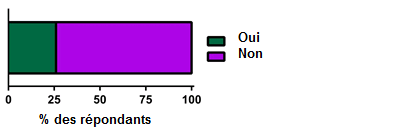

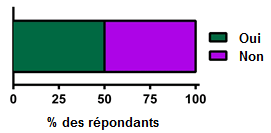

Processus de catégorisation

L'opinion des évaluateurs à l'étape 2 sur le nombre prédéterminé dedemandes acceptées ou refusées (oui/non) du processus de catégorisation était également divisée (voir figure 23). Selon certains évaluateurs, il est trop tôt pour déterminer le nombre approprié; toutefois, de nombreux évaluateurs ont suggéré qu'il serait plus pertinent de leur imposer une étendue à respecter (oui/non) plutôt qu'un nombre absolu (voir tableau 20). Il est important de noter que le nombre de demandes acceptées ou refusées (oui/non) imposé aux évaluateurs est limité en fonction des fonds disponibles pour le concours.

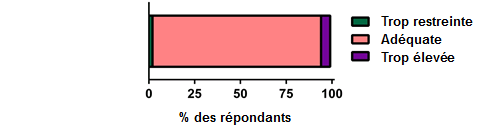

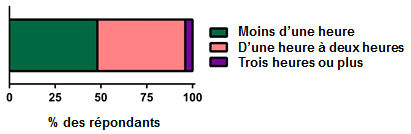

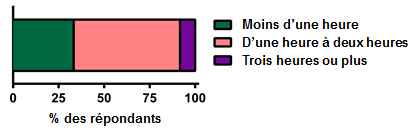

Commentaires des évaluateurs préalables à la réunion

Les commentaires préalables à la réunion qui sont soumis aux IRSC sont mis à la disposition des autres évaluateurs à l'étape 2 afin qu'ils puissent les lire pour se préparer à la réunion en personne. La majorité des évaluateurs les ont lus (voir figure 24A); par contre, la plupart ont indiqué que de lire les commentaires et/ou de voir les décisions de catégorisation prises par les autres évaluateurs n'avait pas souvent influencé leurs propres évaluations (voir figure 24B). La principale raison invoquée par ceux qui n'ont pas lu les commentaires préalables à la réunion est qu'ils ignoraient qu'ils y avaient accès. En moyenne, les évaluateurs ont passé d'une à deux heures à lire les commentaires des autres évaluateurs (voir figure 24C). De plus, selon l'ensemble des évaluateurs, la limite de caractères fixée pour les commentaires préalables à la réunion était adéquate (voir figure 24D).

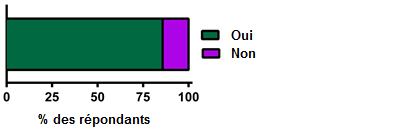

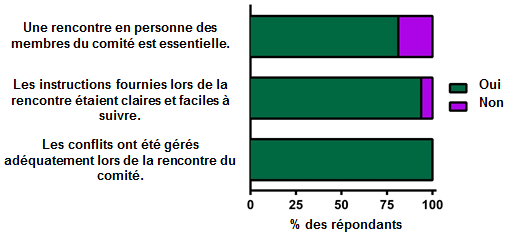

Réunion en personne

Selon la majorité des évaluateurs à l'étape 2, la réunion en personne est nécessaire dans le cadre du nouveau processus d'évaluation (voir figure 25); certains ont toutefois indiqué qu'à long terme, elle ne le serait peut-être plus (voir tableau 21). Certains évaluateurs se sentaient tiraillés : bien qu'ils comprennent l'utilité de la réunion en personne, ils ont du mal à justifier les investissements en temps et en argent nécessaires pour une réunion d'une journée. Dans l'ensemble, les évaluateurs se sont dits très satisfaits des instructions fournies lors de la réunion et de la façon dont les conflits y avaient été gérés (voir figure 25).

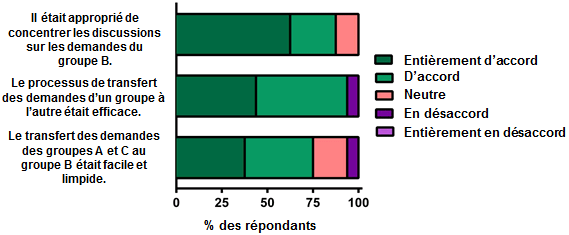

Lors de la réunion en personne, les évaluateurs à l'étape 2 reçoivent des demandes qui ont été classées dans l'un des trois groupes suivants à l'issue du processus de catégorisation : groupe A (demandes à financer sans faire l'objet d'une discussion à la réunion), groupe B (demandes dont il faut discuter à la réunion) et groupe C (demandes qui ne seront pas financées et ne seront pas abordées à la réunion). La première tâche des évaluateurs à la réunion consistait à vérifier si les demandes avaient été classées dans le bon groupe et à faire des changements au besoin. La majorité des évaluateurs ont convenu qu'il était approprié d'axer les discussions à la réunion sur les demandes du groupe B (voir figure 26), étant donné que cette approche donnait plus de temps pour discuter des demandes fortement susceptibles d'être financées; toutefois, certains ont aussi indiqué que le nombre de demandes du groupe B devrait être plus élevé (voir tableau 22). Les évaluateurs ont aussi convenu que le processus de transfert des demandes d'un groupe à l'autre était clair et efficace (voir figure 26). Certains ont suggéré le recours à une forme de calibrage quelconque avant de procéder au transfert de demandes (voir tableau 22).

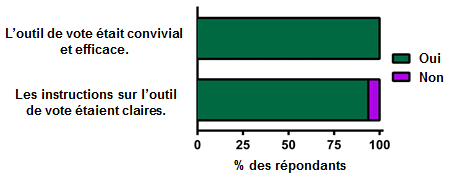

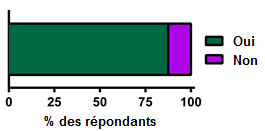

À l'aide d'un outil de vote, les évaluateurs ont indiqué s'ils croyaient que les demandes devraient être classées dans un groupe différent. Tous les évaluateurs ont convenu que l'outil de vote était convivial et efficace, et la majorité a trouvé que les indications sur l'outil de vote étaient claires (voir figure 27). Certains évaluateurs ont mentionné avoir trouvé l'essai de l'outil très utile.

Pour aider les évaluateurs à orienter leurs discussions, un seuil de financement a été ajouté à la liste de demandes. La majorité des évaluateurs (plus de 80 %) s'entendaient pour dire que le seuil de financement les avait effectivement aidés à orienter leurs discussions (voir figure 28).

5. Expérience de RechercheNet

Dans cette section, il sera question de l'expérience de RechercheNet des évaluateurs à l'étape 1 et à l'étape 2.

Étape 1 du processus d'évaluation et utilisation de RechercheNet

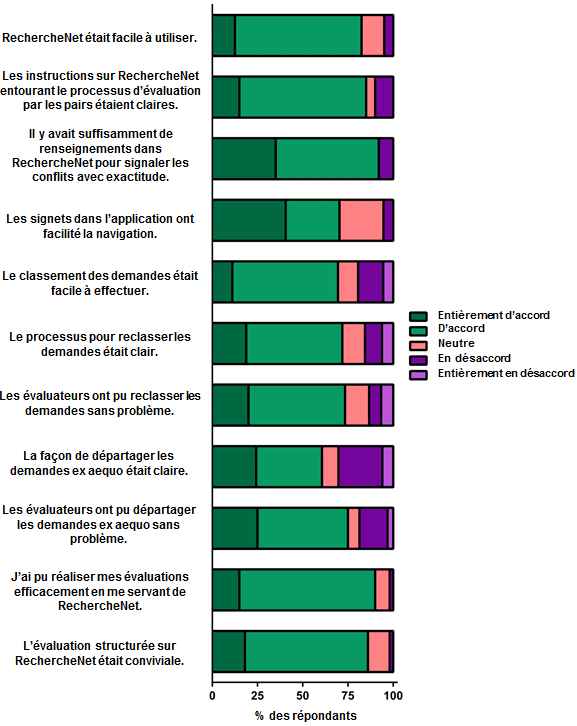

Dans l'ensemble, les évaluateurs à l'étape 1 ont trouvé RechercheNet convivial et facile à utiliser (voir figure 29) : les processus de classement et de reclassement étaient clairs et faciles à utiliser dans RechercheNet, tout comme le processus servant à départager les demandes ex æquo. Des évaluateurs ont signalé que, dans RechercheNet, l'ajout d'une fonctionnalité d'enregistrement automatique et l'affichage de l'échelle de sélection au haut et au bas des formulaires qu'ils remplissent seraient fort utiles. En outre, selon de nombreux évaluateurs, les liens vers les ressources devraient être plus faciles à repérer et se trouver en un seul et même endroit. Il a été suggéré de présenter les liens vers toutes les ressources dans une barre latérale qui serait affichée sur toutes les pages (voir tableau 23).

Selon les évaluateurs, les instructions dansRechercheNet étaient claires, et il y avait suffisamment de renseignements pour qu'ils soient en mesure de signaler les conflits avec exactitude (voir figure 29). Certains ont suggéré que les instructions soient affichées sur plusieurs pages à titre de rappel durant le processus d'évaluation. En outre, plusieurs évaluateurs ont mentionné qu'il n'était pas évident d'après les instructions données qu'il fallait indiquer les forces et les faiblesses liées à chaque critère de sélection (voir tableau 23).

Étape 2 du processus d'évaluation et utilisation de RechercheNet

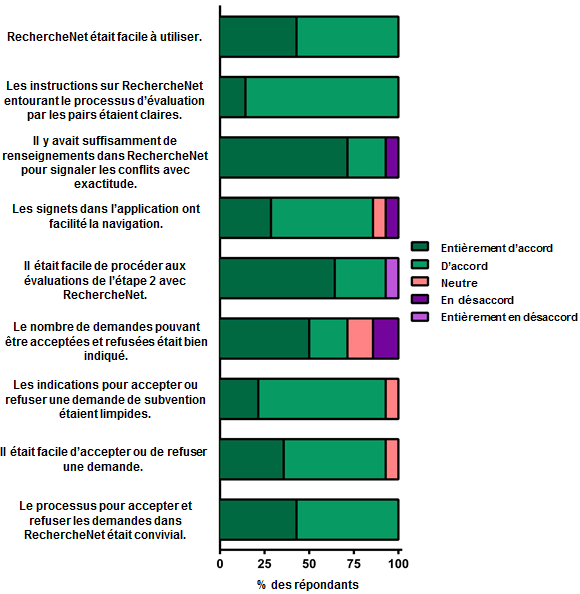

Dans l'ensemble, les évaluateurs à l'étape 2 ont trouvé que RechercheNet était convivial; ils ont de plus mentionné que leur processus d'évaluation à l'aide de ce système avait été efficace (voir figure 30). Le processus de catégorisation des demandes dans RechercheNet était clair et simple à suivre. Les évaluateurs ont mentionné qu'ils auraient aimé pouvoir télécharger les documents relatifs à l'évaluation et à la demande au même endroit. De plus, ils étaient nombreux à dire qu'il devrait être possible de consulter plusieurs écrans à la fois dans RechercheNet afin d'éviter de devoir constamment naviguer d'une page à l'autre. Les évaluateurs auraient aussi aimé pouvoir consulter la liste de candidats par ordre décroissant de cote plutôt qu'en ordre alphabétique. En outre, afin de réduire le fardeau des évaluateurs à l'étape 2, il a été suggéré que les commentaires des évaluateurs à l'étape 1 soient réunis de sorte que tous les commentaires relatifs à la qualité de l'idée, par exemple, se trouvent au même endroit dans le document (voir tableau 24).

Selon les évaluateurs, les instructions dansRechercheNet étaient claires, et il y avait suffisamment de renseignements dans RechercheNet pour qu'ils soient en mesure de signaler les conflits avec exactitude (voir figure 30). Certains ont souligné que les limites de caractères imposées aux évaluateurs à l'étape 2 n'étaient pas précisées dans les instructions. Certains ont aussi demandé que les instructions relatives à la catégorisation (et plus particulièrement les quotas de demandes à accepter [oui] et à refuser [non]) soient indiquées dans RechercheNet à titre de rappel. En outre, certains évaluateurs croyaient qu'il est important de connaître le processus d'évaluation à l'étape 1 et de savoir comment les IRSC ont décidé des demandes qui passeraient à l'étape 2 (voir tableau 24).

6. Satisfaction globale à l'égard de la structure du volet Projet

Dans cette section, il sera question de la satisfaction globale des candidats et des évaluateurs (étape 1 et étape 2) à l'égard du nouveau processus et des éléments conceptuels du volet Projet.

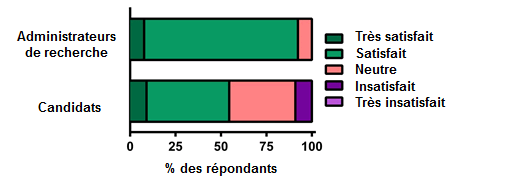

Satisfaction des évaluateurs à l'égard de l'étape 1 du processus d'évaluation

La majorité des évaluateurs à l'étape 1 se sont dits satisfaits du nouveau processus d'évaluation structurée (voir figure 31). Ils ont néanmoins indiqué qu'il serait possible d'améliorer le processus si les IRSC veillaient à ce que les évaluateurs soumettent leurs évaluations dans des délais raisonnables. De plus, certains étaient d'avis que les instructions devraient être améliorées, et que les IRSC pourraient y arriver en donnant des instructions étape par étape aux évaluateurs à l'étape 1. Certains évaluateurs ont aussi suggéré qu'il soit possible de consulter simultanément plusieurs demandes dans RechercheNet, une fonctionnalité qui leur serait extrêmement utile (voir tableau 25).

Satisfaction des évaluateurs à l'égard de l'étape 2 du processus d'évaluation

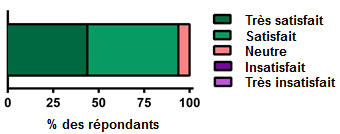

Plus de 90 % des évaluateurs à l'étape 2 se sont dits satisfaits de l'étape 2 du processus d'évaluation (voir figure 32). De nombreux évaluateurs ont dit avoir aimé participer au nouveau processus d'évaluation; ils l'ont trouvé bien pensé, juste, et plus efficace que le processus actuel d'évaluation par les pairs : dans l'ensemble, une amélioration par rapport au processus actuel (voir tableau 26). Certains évaluateurs ont suggéré que les documents relatifs à la demande et les documents des évaluateurs à l'étape 1 puissent être consultés à l'endroit où ils saisissent les renseignements à l'étape 2. Certains évaluateurs à l'étape 2 ne comprenaient pas tout à fait les critères d'évaluation qu'ils devaient respecter et ont souligné qu'il serait important de leur fournir un document à ce sujet. De nombreux commentaires portaient sur les évaluations à l'étape 1, précisant notamment qu'il aurait été utile de connaître la formation et l'expérience des évaluateurs à l'étape 1, et que la qualité des commentaires des évaluateurs à l'étape 1 devait être améliorée de façon significative (voir tableau 26).

Satisfaction des candidats à l'égard du processus d'évaluation

Les réponses des candidats ont été classées en trois groupes : les candidats qui ont été retenus (retenus), les candidats dont les demandes sont passées à l'étape 2 mais n'ont pas été retenues (non retenus après l'étape 2), et les candidats non retenus à la suite de l'étape 1 (non retenus).

Selon la majorité des candidats non retenus après l'étape 2 et des candidats retenus, les évaluations de leur demande étaient cohérentes : les cotes attribuées et les justifications à l'appui correspondaient (voir figure 33A). Plus de 50 % des candidats dont les demandes ne sont pas passées à l'étape 2 ont mentionné que les évaluations reçues n'étaient pas cohérentes (voir figure 33A). Certains candidats ont même dit s'interroger sur la validité du nouveau processus d'évaluation par les pairs, compte tenu de la grande variabilité observée d'un évaluateur à l'autre. Plusieurs candidats ont indiqué dans leurs commentaires que les cotes ne correspondaient pas aux justifications, ou que lorsqu'elles y correspondaient, qu'elles ne correspondaient pas au classement (voir tableau 27).

Certains candidats trouvaient que les commentaires reçus des évaluateurs n'étaient pas constructifs et étaient même trop négatifs ou critiques, si bien que certains se sont demandé si les évaluateurs à l'étape 1 savaient que leurs commentaires leur seraient transmis (voir figure 33B et tableau 28). La majorité des candidats ont indiqué que le processus d'évaluation structurée était bénéfique, car une cote et des commentaires justificatifs sont fournis pour chaque critère de sélection (voir figure 33C). Toutefois, les candidats ont soutenu que certains évaluateurs ont donné très peu de commentaires justifiant de leurs cotes, et il était difficile pour les candidats de savoir quelles suggestions ils devraient suivre parmi celles formulées, étant donné que certains évaluateurs avaient des points de vue divergents (voir tableau 29).

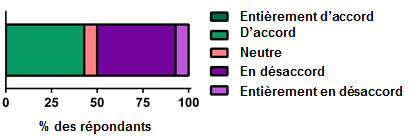

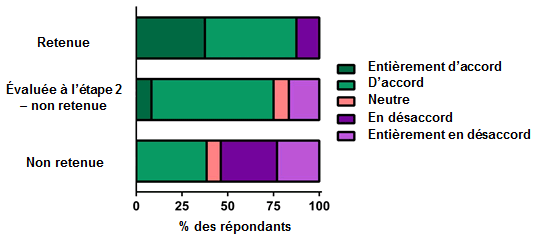

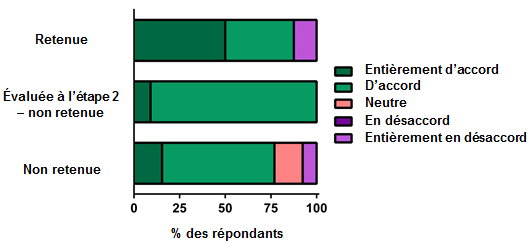

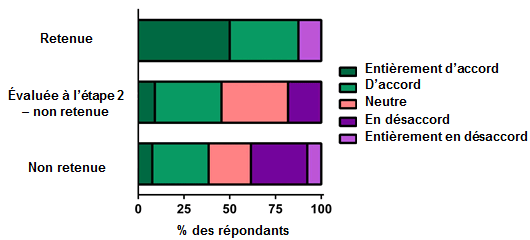

La majorité des candidats retenus étaient d'avis que le processus d'évaluation structurée était juste et transparent (voir figure 33D). Près de la moitié des candidats non retenus après l'étape 2 ont indiqué que le processus d'évaluation était juste et transparent; le tiers n'était ni en accord, ni en désaccord. Un peu plus du tiers des candidats non retenus ont dit ne pas croire que le processus d'évaluation était juste ou transparent; cependant, plus de 50 % des candidats non retenus étaient d'avis que le processus d'évaluation était juste ou étaient neutres à ce sujet. Les candidats aimeraient vraiment savoir comment les cinq évaluations sont pondérées et comment les IRSC gèrent les évaluations divergentes des autres (voir tableau 30).

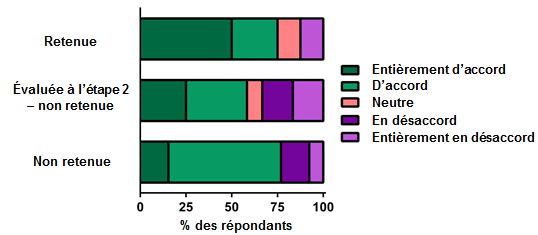

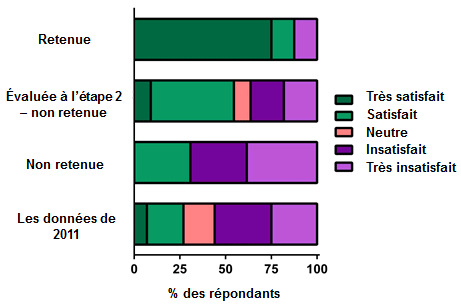

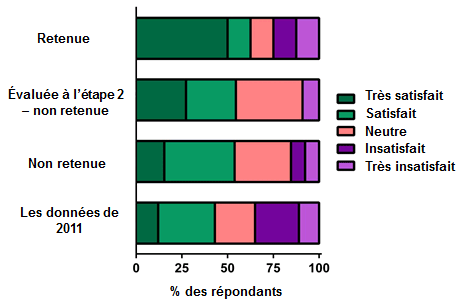

Les candidats ont indiqué leur degré de satisfaction relativement à divers aspects du processus d'évaluation et à l'expérience globale d'évaluation (voir figure 34). Ceux qui ont été retenus ont indiqué un degré de satisfaction élevé quant à la cohérence des commentaires dans l'évaluation par les pairs. Sans surprise, ce degré de satisfaction est moins élevé chez les candidats dont les demandes sont passées à l'étape 2, mais qui n'ont pas été retenus, et encore moins chez les candidats qui n'ont pas été retenus à l'issue de l'étape 1 (voir figure 34A). Tant les candidats non retenus après l'étape 2 que les candidats retenus se sont dits très satisfaits de la qualité des commentaires reçus dans le cadre de l'évaluation par les pairs. Seulement la moitié des candidats qui n'ont pas été retenus se sont dits satisfaits de la qualité des commentaires reçus (voir figure 34C).

Environ 50 % seulement de l'ensemble des candidats se sont dits satisfaits de la clarté des critères de sélection (voir figure 34B). Fait intéressant, le degré de satisfaction à l'égard de la clarté du système de sélection dépendait grandement du groupe de candidats. Environ 75 % des candidats retenus se sont dits satisfaits de la clarté du système de cotation, tandis que ce pourcentage a chuté à 50 % seulement chez les candidats non retenus après l'étape 2, et à moins de 25 % chez les candidats non retenus (voir figure 34D). De même, le degré de confiance des candidats à l'égard du processus d'évaluation est aussi fonction du groupe de candidats. Les candidats qui ont été retenus étaient ceux qui avaient la plus grande confiance dans le processus, les candidats n'ayant pas été retenus, ceux qui avaient le moins confiance dans le processus. Les candidats non retenus après l'étape 2 se trouvaient entre les deux (voir figure 34E).

Globalement, tant les candidats retenus que les candidats non retenus après l'étape 2 se sont dits satisfaits du nouveau processus d'évaluation structurée (voir figure 35). Le degré de satisfaction à l'égard du processus d'évaluation chez les candidats qui n'ont pas été retenus à l'issue de l'étape 1 était partagé : environ 50 % des candidats non retenus se sont dits généralement satisfaits du processus d'évaluation, et environ 50 %, insatisfaits. Les candidats ont proposé des façons d'améliorer l'expérience d'évaluation de leur point de vue (voir tableau 31). Comme de nombreux évaluateurs s'inquiétaient du manque de cohérence entre les différentes évaluations d'une même demande, les candidats ont suggéré le recours à un processus d'arbitrage pour les demandes dont les évaluations divergent, ou encore que les IRSC soient plus transparents quant à la façon dont les cotes et les classements des évaluateurs sont intégrés à la suite de l'étape 1. En outre, les candidats souhaitaient mieux comprendre le processus d'évaluation. Par exemple, ils avaient certaines interrogations quant aux demandes passées à l'étape 2 qui n'ont pas fait l'objet de discussions et n'ont pas été financées (demandes du groupe C) et les raisons expliquant cette situation. Les candidats étaient aussi d'avis qu'ils devraient être informés de la raison pour laquelle leur demande n'est pas passée à l'étape 2. En ce qui concerne les candidats souhaitant présenter une demande à nouveau, ils étaient d'avis qu'ils devraient savoir si les évaluateurs seraient les mêmes lors du prochain concours. Il est aussi important pour les candidats que les IRSC indiquent plus précisément quels renseignements doivent être présentés dans chaque section de la demande structurée, de sorte que les candidats et les évaluateurs interprètent les sections de la même façon.

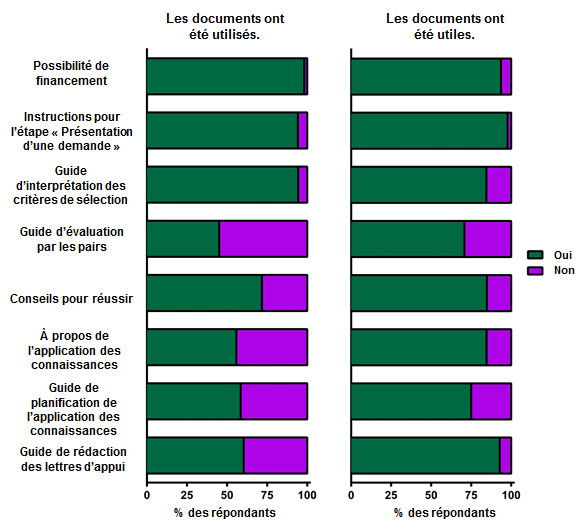

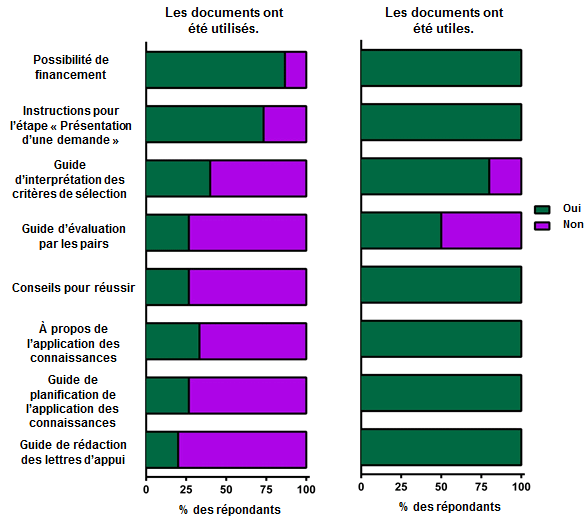

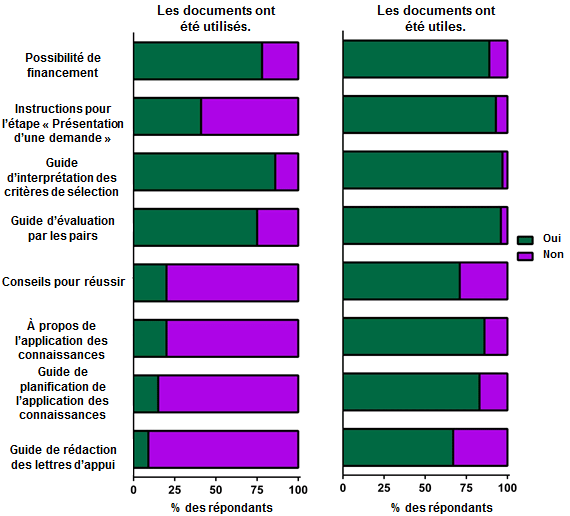

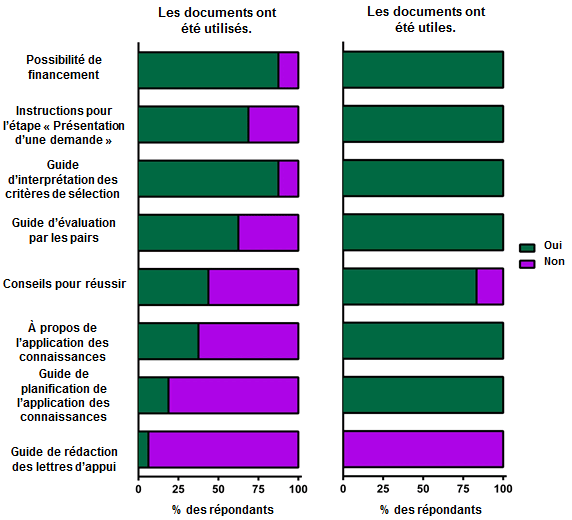

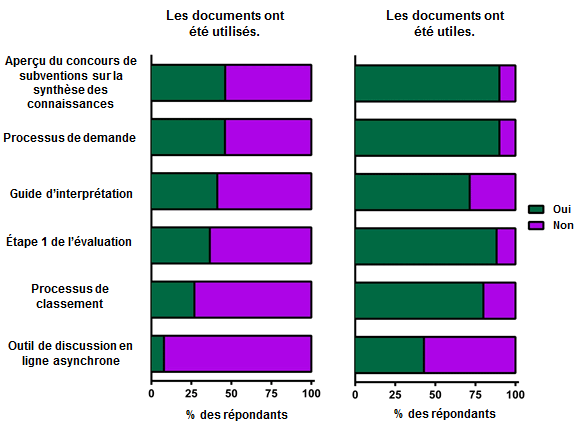

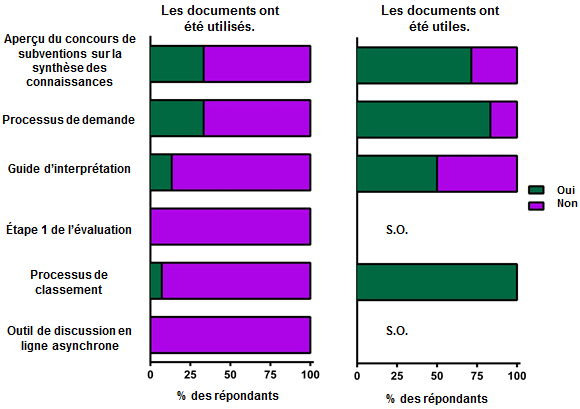

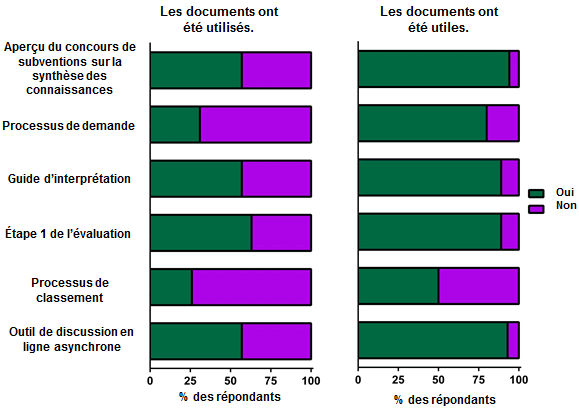

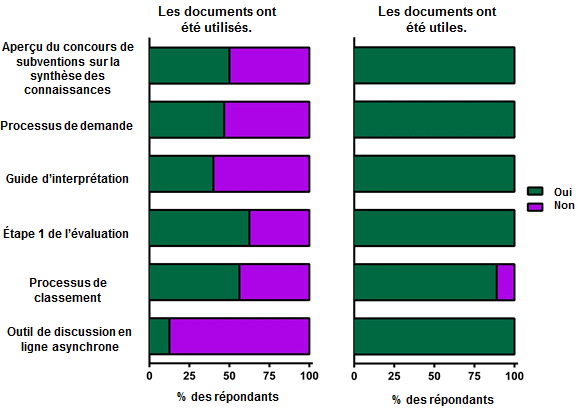

Documents et activités d'apprentissage préparés pour le projet pilote de synthèse des connaissances

Les IRSC ont créé divers documents pour aider les participants au concours pilote de l'automne 2013 (candidats, administrateurs de recherche, évaluateurs à l'étape 1 et évaluateurs à l'étape 2) à effectuer leurs tâches. Tout au long des sondages, des commentaires ont été recueillis sur l'utilisation et l'utilité de ces documents. Les répondants ont utilisé des documents différents en fonction de leur rôle dans le concours, mais la majorité de ceux qui les ont utilisés les a trouvés utiles (voir figures 36 et 37). Ils ont toutefois souligné que les documents devraient être moins nombreux et qu'ils devraient tous se trouver au même endroit (voir tableaux 32 et 33).

Conclusions et facteurs à prendre en considération pour les prochains concours pilotes

Le concours de Synthèse des connaissances de l'automne 2013 a servi de premier concours pilote complet du volet Projet. L'échantillon était très petit et étalé vers les chercheurs des thèmes 3 et 4; néanmoins, il s'agissait d'un bon premier test de nouveaux éléments conceptuels du volet Projet et du nouveau processus d'évaluation par les pairs. De nombreux aspects positifs de ce concours serviront de point de départ aux prochains concours pilotes.

En raison des limites de ce concours pilote, les résultats doivent être interprétés avec prudence; les réponses positives ne signifient pas nécessairement que la conception est appropriée et vice versa. Les candidats, les administrateurs de recherche et les évaluateurs se familiarisent avec la nouvelle technologie et les nouveaux processus; il pourrait donc s'écouler un certain temps avant que des améliorations puissent être mesurées. Les IRSC sont aussi encore en période d'apprentissage et apportent des améliorations aux nouveaux processus en se fondant sur les commentaires du milieu de la recherche. Les résultats continueront d'être utiles pour améliorer la mise en œuvre des éléments conceptuels ou l'approche de formation. De plus, d'autres projets pilotes seront réalisés dans le cadre d'autres concours.

De nombreuses recommandations sont à l'étude en prévision de futurs concours pilotes. Veuillez noter que les recommandations ne seront pas toutes mises en œuvre lors d'un projet pilote à venir. Il se pourrait que l'application de certaines recommandations soit retardée tant qu'il n'y aura pas plus de données pour appuyer de l'évaluation.

RechercheNet

- Une fonction d'enregistrement automatique devrait être mise en place pour que le travail des candidats et des évaluateurs soit enregistré avant la fermeture de leur session après une période d'inactivité.

- La possibilité d'ajouter des figures dans la demande structurée devrait être étudiée.

Limites de caractères

- L'augmentation de la limite de caractères de chaque section de la demande structurée devrait être envisagée.

- La limite de caractères imposée aux évaluateurs devrait être revue.

- Il pourrait être plus approprié d'employer des limites de mots; l'utilisation de sigles et de jargon serait réduite.

Critères de sélection

- La distinction entre « Qualité de l'idée » et « Importance de l'idée » n'est pas claire. Les IRSC devraient soit réécrire l'interprétation des deux critères de sélection en veillant à éliminer tous les chevauchements, soit envisager de combiner les deux sections en une seule, intitulée « Contexte ».

- Les critères de sélection ne devraient pas être pondérés de façon égale. Une plus grande pondération devrait être accordée à la section « Approche », aux dépens des critères « Qualité de l'idée » et/ou « Importance de l'idée ».

Étape 1 – processus d'évaluation structurée

- Il faudrait donner des instructions,pour aider à interpréter les opinions divergentes des évaluateurs, aux candidats qui prévoient resoumettre leur demande à un autre concours.

- Une fois que ce processus aura été renforcé, il sera important de faire connaître au milieu de la recherche la façon dont le classement des cinq évaluateurs est consolidé (c.-à-d. comment il est déterminé que certaines demandes passent à l'étape 2). Ce sera particulièrement important pour les organismes de financement qui souhaitent adopter le nouveau processus d'évaluation par les pairs des IRSC, étant donné qu'il est difficile de consolider les évaluations et de gérer les évaluations divergentes des autres.

- Les évaluateurs à l'étape 1 devraient être informés du fait que les évaluateurs à l'étape 2 se basent sur leurs évaluations pour prendre des décisions relatives au financement et qu'une grande qualité s'impose.

- Les IRSC devraient envisager de demander aux évaluateurs à l'étape 2 de formuler des commentaires sur la qualité des évaluations réalisées par leurs pairs à l'étape 1.

Étape 1 – pièces jointes

- Il devrait être envisagé d'admettre les pièces jointes concernant la méthodologie autres que les tableaux ou les figures, étant donné que l'espace fourni pour donner tous les renseignements sur la méthodologie est considérablement réduit.

Étape 1 – échelle de sélection

- Des solutions de rechange à l'échelle de sélection actuelle (ABCDE) devraient être envisagées, étant donné que les évaluateurs à l'étape 1 ne se sentent pas à l'aise de recourir à toute l'étendue de l'échelle de sélection, ce qui complique la tâche lorsque vient le temps de faire la différence entre les demandes. Voici quelques suggestions :

- Opter pour d'autres lettres (p. ex. LMNOP). Il se peut que les universitaires trouvent que les lettres sont trop semblables aux notes attribuées à l'école et ne se sentent pas à l'aise d'attribuer des C, des D ou des E.

- Subdiviser le haut de l'échelle. S'il y a cinq lettres, c'est dire qu'il y a un écart de 20 % d'une cote à l'autre, et de nombreuses différences sont beaucoup plus subtiles. L'échelle A+/A/A-/B+/B/B-/C a été suggérée par un évaluateur à l'étape 1.

Étape 1 – discussion en ligne

- Les IRSC devraient déterminer s'il doit être obligatoire de prendre part à une discussion en ligne et dans quelles circonstances.

- Les IRSC devraient consolider le rôle d'animateur/président virtuel et veiller à ce que des personnes soient en mesure de l'assumer lors de concours futurs.

- Les IRSC pourraient créer un arbre de décision servant à déterminer quand une discussion en ligne doit avoir lieu, lequel pourrait être utilisé par un président ou un évaluateur.

Étape 2 – catégorisation des demandes

- Il ne faudrait pas imposer un nombreabsolu de demandes acceptées ou refusées (oui/non) aux évaluateurs, au risque que des demandes soient classées dans la mauvaise catégorie. On devrait plutôt déterminer une étendue que les évaluateurs pourront utiliser à leur discrétion.

Processus global – documents sur le concours pilote

- Un grand nombre de documents et de formations sont mis à la disposition des participants au concours pilote. L'utilité de chacun des documents devrait être évaluée : s'il y en a trop, les participants risquent de ne pas tous les lire et de passer à côté de documents essentiels.

- Les liens vers les documents et les leçons créés pour chacun des concours pilotes devraient tous être réunis en un même endroit afin que les participants trouvent toujours ce dont ils ont besoin.

Recommandations en prévision d'analyses

Le plan de recherche créé en vue de la réforme de la série de programmes ouverts des IRSC décrit un éventail d'analyses qui seront menées tout au long de la période de mise en œuvre pour veiller à ce que les modifications apportées aux programmes actuels fonctionnent correctement. Pour ce qui est de l'étude actuelle, nous proposons les analyses supplémentaires suivantes :

- Les candidats ont indiqué que les évaluateurs à l'étape 1 manquaient de cohérence dans leurs évaluations (la cote attribuée pour un critère de sélection ne correspondait pas à la justification écrite). Les IRSC se pencheront sur la question; si ce problème demeure important avec un échantillon de plus grande taille, des études approfondies seront réalisées pour trouver les raisons de ces écarts.

- Certains candidats et évaluateurs à l'étape 2 ont trouvé les commentaires des évaluateurs à l'étape 1 insuffisants pour justifier les cotes qu'ils avaient attribuées. Les IRSC consulteront les évaluations de l'étape 1 pour déterminer si c'est le cas, et formuleront des recommandations pour en améliorer leur qualité.

- Afin d'évaluer la validité du processus en plusieurs étapes, les IRSC enquêteront sur la fréquence et la mesure dans laquelle le classement des demandes a changé après l'étape 1, avant l'étape 2 et à l'issue du processus.

Annexe 1 : Données démographiques des sondages

Participants aux sondages

Administrateurs de recherche

Taux de réponse

Le sondage a été envoyé à 32 administrateurs de recherche. De ce nombre, 16 ont envoyé une réponse, et 15 ont répondu au sondage en entier (taux de réponse de 46,9 %). Tous les répondants résidaient au Canada et ont répondu au sondage en anglais.

Profil démographique des répondants

Les administrateurs se sont classés dans les groupes « administrateur de recherche » (93,4 %) ou « facilitateur de la recherche » (6,6 %).

Expériences antérieures – concours de subventions de Synthèse des connaissances et évaluation par les pairs

Neuf administrateurs de recherche (56,3 %) ont dit avoir déjà présenté une demande dans le cadre d'un concours de subventions de Synthèse des connaissances.

Candidats (après présentation de la demande)

Taux de réponse

Le sondage a été envoyé aux 77 candidats qui ont présenté une demande dans le cadre du concours de Synthèse des connaissances de l'automne 2013. Sur les 60 candidats qui ont répondu au sondage, 53 ont répondu à toutes les questions (taux de réponse de 68,8 %). Tous les répondants sauf un résidaient au Canada (98,3 %), et 91,7 % ont répondu au sondage en anglais.

Profil démographique des répondants

Les candidats se sont classés dans les groupes « chercheur en début de carrière » (35,6 %), « chercheur en milieu de carrière » (25,4 %), « chercheur chevronné » (35,6 %) ou « autre » (3,4 % : un utilisateur des connaissances et un cocandidat). Les candidats ont indiqué que leur poste actuel était « professeur » (28,8 %), « professeur agrégé » (18,6 %), « professeur adjoint » (28,8 %), « scientifique » (10,2 %), « chercheur » (6,8 %) ou « autre » (6,8 % : un clinicien, un scientifique chevronné, un boursier postdoctoral et un administrateur de recherche).

La plupart des candidats ont indiqué que leur principal domaine de recherche est la « recherche sur les services et les systèmes de santé » (44,1 %), suivie de la « recherche clinique » (32,2 %), de la « recherche sur les facteurs sociaux, culturels et environnementaux qui influent sur la santé des populations » (22 %) et de la « recherche biomédicale » (1,7 %).

Expériences antérieures – concours de subventions de Synthèse des connaissances et évaluation par les pairs

Trente-quatre candidats (57,6 %) ont indiqué avoir déjà présenté une demande dans le cadre d'un concours de subventions de Synthèse des connaissances. Dans le concours actuel, 67,6 % des candidats ont présenté une nouvelle demande, tandis que 32,4 % ont présenté une demande révisée.

Trente-deux candidats (54,2 %) ont déjà été pairs évaluateurs pour les IRSC et ont fait partie du comité des subventions de Synthèse des connaissances (14 %), d'un comité de subventions (48,8 %), d'un comité de bourses (16,3 %) ou d'un autre comité (20,9 % : quatre ont fait partie du comité des subventions de Planification et dissémination, un du comité des subventions de nouveaux chercheurs, un du comité des subventions pour l'application des connaissances, et un du comité des bourses postdoctorales Banting; un candidat a répondu « sans objet »).

Évaluateurs à l'étape 1

Taux de réponse

Le sondage a été envoyé aux 49 évaluateurs qui ont participé à l'étape 1 de l'évaluation. Sur les 40 évaluateurs qui ont répondu au sondage, 36 ont répondu à toutes les questions (taux de réponse de 81,6 %). À l'exception de deux répondants, tous résidaient au Canada (95 %); 92,5 % ont répondu au sondage en anglais.

Profil démographique des répondants

Les évaluateurs se sont classés dans les groupes « chercheur en début de carrière » (20 %), « chercheur en milieu de carrière » (30 %), « chercheur chevronné » (22,5 %), « utilisateur des connaissances » (22,5 %) ou « autre » (5 % : un clinicien-chercheur et un administrateur de recherche). Les évaluateurs ont indiqué que leur poste actuel était « professeur » (17,5 %), « professeur agrégé » (7,5 %), « professeur adjoint » (32,5 %), « chercheur » (10 %), « clinicien » (2,5 %), « scientifique chevronné » (2,5 %), « scientifique » (2,5 %) ou « autre » (25 % : quatre administrateurs, quatre cadres de direction, un bibliothécaire de recherche, et un bailleur de fonds dans le domaine de la santé).

La plupart des répondants ont indiqué que leur principal domaine de recherche est la « recherche sur les services et les systèmes de santé » (41 %), suivie de la « recherche clinique » (25,6 %), de la « recherche sur les facteurs sociaux, culturels et environnementaux qui influent sur la santé des populations » (25,6 %) et de la « recherche biomédicale » (7,7 %).

Expérience antérieure – évaluation par les pairs